서론

지난 Chapter 7 Multiple Regression : Model Validation and Diagnostics1 글에 연이은 글입니다.

지난번에 Internally studentized residual의 성질에 대해 절반 정도 알아보았고, 오늘은 Externally studentized residual과 Influential point에 대해 알아보겠습니다.

본 포스팅은 서울대학교 25학년도 1학기 대학원 응용통계 수업 내용의 일부를 정리하고,

Rencher, Alvin C., and G. Bruce Schaalje. 2008. *Linear Models in Statistics*. 2nd ed를 참고합니다.

본론

1. Internally studentized residual의 성질

iii) $var(r_i) = 1$

iv) $cov(r_i,r_j) = corr(r_i,r_j) = -\frac{h_{ij}}{\sqrt{1-h_{ii}}\sqrt{1-h_{jj}}}$

v) $\frac{r_i^2}{n-p-1} ~ Beta(\frac{1}{2}, {\frac{n-p-2}{2}})$

proof)

사실 iii)은 iv)의 특수한 경우입니다. 그렇기 때문에 iv)만 증명해 봅시다.

먼저 Lemma를 하나 봅시다.

1-2 Lemma 1

Orthogonal Matrix $P$가 있다고 해봅시다.

또 r 차원 확률변수 $\eta \in \mathbb{R^r}$가 있다고 하겠습니다.

만약 모든 Orthogonal matrix $P$에 대해 $\eta \overset{d}{=} P\eta$가 성립하면 아래의 좋은 성질이 성립합니다.

1. $\frac{\eta}{||\eta||}$ and $||\eta||$ are independent.

2. $\frac{\eta}{||\eta||}$ is uniformly distributed on $\{x \in \mathbb{R^r} \space : \space ||x|| = 1 \}$.

sphere에서 균등분포를 따릅니다.

통계를 공부하면서 알고 있으면 좋은 정리입니다!

이 Lemma에 대해 증명을 하기보다 직관을 정리해 봅시다.

직관은 더보기에 정리하겠습니다.

orthogonal matrix는 반사와 회전에 관한 행렬입니다. (reflection과 rotation을 섞은 변환입니다.)

여기선 단순하게 벡터를 반사시킨 후 회전시키는 행렬이라고 생각합시다.

그럼 모든 orthogonal matrix로 변환시켜도 분포가 같으려면 어떻게 되어야 할까요? 아무리 대칭과 회전을 하더라도 분포가 같으려면 일단 support가 ball(공)이나 sphere(구,껍질)의 형태이고 분포는 대칭을 띄어야 할 것 같습니다.

(함숫값, 즉 likelihood를 보지 마시고 support를 생각해 보세요! 속이 꽉 찬 원?인데 무한한 반지름을 가졌다고 생각할 수 있겠네요.)

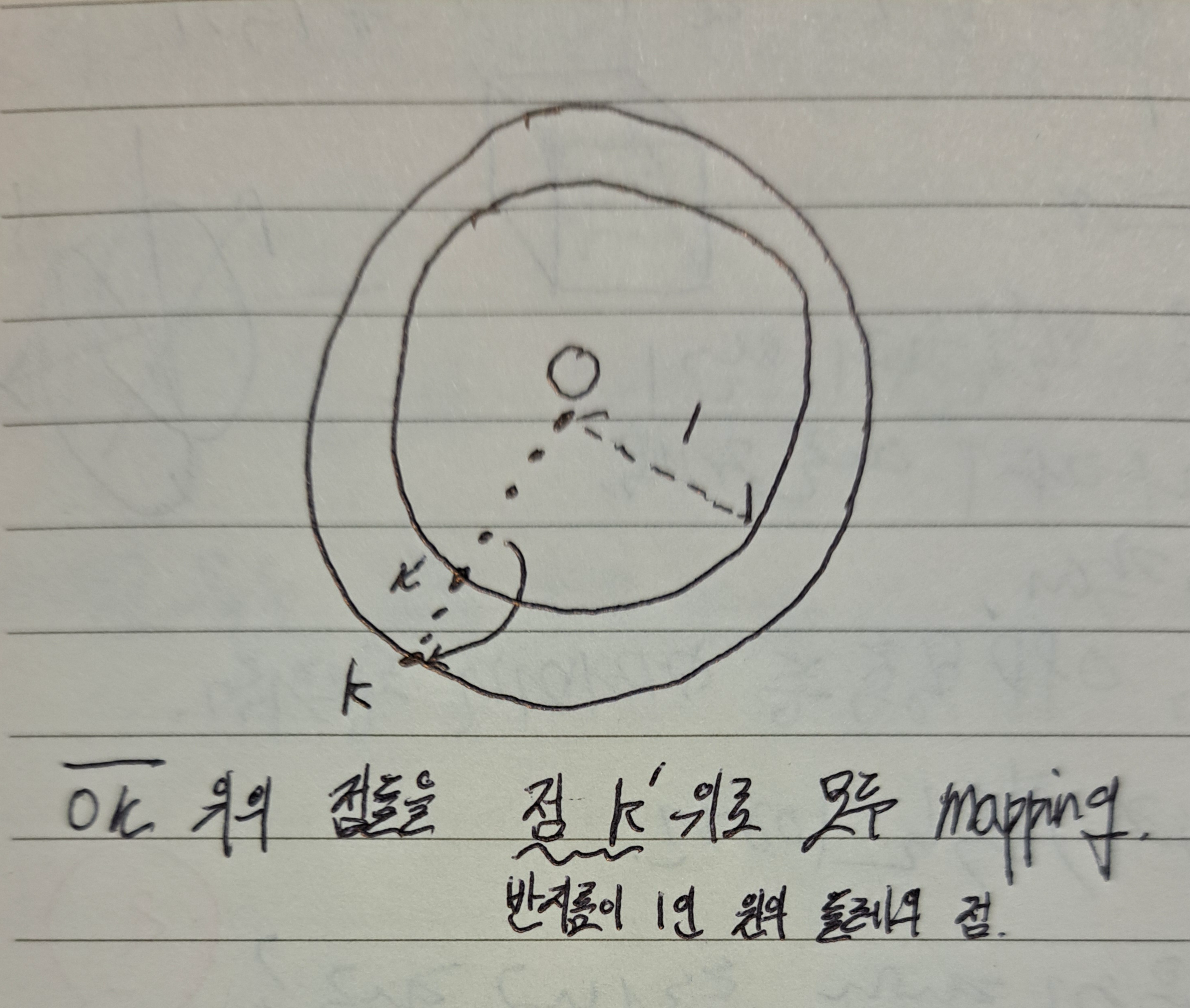

그러면 반지름을 $r \in (0,\infty]$라고 할 때, 둘레 위의 한 점을 K라고 합시다.(무한대면 K는 없겠지만)

이때, 원점과 K사이 직선에 존재하는 모든 점들의 measure를 $r=1$의 둘레에 위치하는 점으로 모은다고 생각하면 $\frac{\eta}{||\eta||}$ 분포가 왜 $\{x \in \mathbb{R^r} \space : \space ||x|| = 1 \}$에서 uniformly distributive인지 알 수 있습니다.

아래 그림과 같습니다. $||\eta||$로 나누기 때문에 길이가 1이 되기 때문에 이런 직관이 성립합니다!

전체적으로 대칭이니 $r=1$인 둘레 위에 모이는 measure도 모두 같겠네요. 즉, uniformly distributive되어 있겠습니다.

본격적으로 iv)를 증명해 보겠습니다.

먼저 $(I-H)$가 projection matrix이기 때문에 column들이 orthogonal 한 matrix $Q$ s.t. $(I-H) = QQ^T$가 존재합니다.

이게 왜 존재할까요? 어떤 full column rank $m x n$ matrix X가 있다고 해봅시다. 이때 $X(X^TX)^{-1}X^T$는 이 X로의 projection matrix가 됩니다. 그러면 이 X의 column space의 orthogonal basis를 구성하고 n개의 orthogonal vector로 $Q$라는 matrix를 구성하면 어떨까요? $Q$가 span하는 공간은 $X$가 span하는 공간과 같고 그 projection matrix는 $Q$의 성질에 따라 $QQ^T$가 되겠죠.

$(I-H)\boldsymbol{y} = (I-H)\boldsymbol{\varepsilon} = QQ^T\boldsymbol{\varepsilon}$.

위의 식은 자명합니다 여기서 $\boldsymbol{\mu} = Q^T \boldsymbol{\varepsilon}$로 정의합시다.

그러면 $\boldsymbol{\mu} ~ N(\boldsymbol{0},\sigma^2 I)$이 되기 때문에 모든 orthgonal matrix $P$에 대해 $P\boldsymbol{\mu} \overset{d}{=} \boldsymbol{\mu}$가 성립합니다.

Lemma1 이 이렇게 적용되는군요. 분산이 이렇게 단순한 정규분포에서 깔끔하게 성립한다는 사실을 기억할만하겠네요.

이렇게 정의한 이유는 Lemma1과 본 정리를 연결하려면 $|\boldsymbol{\mu}|$가 $\hat{\sigma}$의 꼴이 되어야 하는데 마침 $\hat{\sigma}^2 = \boldsymbol{\varepsilon}^T QQ^T \boldsymbol{\varepsilon}$이어서 깔끔하게 떨어지기 때문도 있습니다.

다음 문단에서 자세히 설명하겠습니다.

$\therefore \frac{\boldsymbol{\mu}}{||\boldsymbol{\mu}||} \perp ||\boldsymbol{\mu}||$,

where $||\boldsymbol{\mu}|| = \sqrt{\boldsymbol{\varepsilon}^T QQ^T \boldsymbol{\varepsilon}} = \sqrt{\boldsymbol{\varepsilon}^T (I-H) \boldsymbol{\varepsilon}}=\sqrt{\boldsymbol{\varepsilon}^T (I-H)(I-H) \boldsymbol{\varepsilon}} = \sqrt{\boldsymbol{e}^T\boldsymbol{e}} = \sqrt{SSE} = \sqrt{n-p-1}\hat{\sigma}$ By lemma 1.

(다들 아시겠지만 $(I-H)\boldsymbol{y} = (I-H)X\beta + (I-H)\boldsymbol{\varepsilon} = (I-H)\boldsymbol{\varepsilon} \space \because (I-H)X = 0$이라는 사실을 통해 전개했습니다.)

자 이제 $\frac{(I-H)\boldsymbol{\varepsilon}}{\sqrt{n-p-1}\hat{\sigma}}$ 가 uniformly distributive 되어 있다는 점을 활용하여 covariance를 구해봅시다!

$\boldsymbol{r}$ 은 internally studentized residual을 의미합니다.

$var(\boldsymbol{r}) = var(\frac{D^{-1} (I-H)\boldsymbol{y}}{\hat{\sigma}}) \space \because D = diag(\sqrt{1-h_{ii}})$

$= var(\frac{D^{-1}(I-H)\boldsymbol{\varepsilon}}{\hat{\sigma}})$ (위에 적어놓은 단순한 변환입니다.)

$= D^{-1}var(\frac{QQ^T\boldsymbol{\varepsilon}}{\hat{\sigma}})D^{-1}$ (I-H를 Q로 바꾸고, $D^{-1}$를 밖으로 빼냈습니다.)

$= (n-p-1)D^{-1}Qvar(\frac{\boldsymbol{\mu}}{||\boldsymbol{\mu}||})Q^TD{-1}$

여기서 우리는 $\frac{\boldsymbol{\mu}}{||\boldsymbol{\mu}||}$이 uniformly distributied 되어 있다는 사실을 통해 분산을 구할 건데요. 사실 척 봤을 때 분산을 모르겠습니다.

직접 구해봅시다. 사용할 사실은 Lemma1의 $\frac{\eta}{||\eta||} \perp ||\eta||$입니다.

우리의 경우 $\eta = Q\boldsymbol{\varepsilon}$입니다. 그러면 $E[\eta] = 0$이겠죠?

그러면 조금 계산을 해보면 $var(\eta) = E[\frac{\eta}{||\eta||}\frac{\eta}{||\eta||}^T] E[||\eta||^2]$이라는 사실을 알 수 있습니다. 왜냐면 $\frac{\eta}{||\eta||}$의 expectation이 0이라 그렇습니다. uniformly distributive이기 때문이죠.

$E[\frac{\eta}{||\eta||}\frac{\eta}{||\eta||}^T]= var(\frac{\eta}{||\eta||})$ 이고 $E[||\eta||^2] = (n-p-1)\sigma^2, var(\eta) = \sigma^2 I$이기 때문에, $var(\frac{\eta}{||\eta||}) = \frac{1}{(n-p-1}I$라는 사실을 알 수 있겠네요.

그러므로 $(n-p-1)D^{-1}Qvar(\frac{\boldsymbol{\mu}}{||\boldsymbol{\mu}||})Q^TD{-1} = D^{-1}(I-H)D^{-1}$입니다.

$\therefore

\mathrm{Cov}(r_i, r_j) =

\begin{cases}

1, & \text{if } i = j \\

\displaystyle\frac{-h_{ij}}{\sqrt{1 - h_{ii}} \sqrt{1 - h_{jj}}}, & \text{if } i \ne j

\end{cases}

$

이번에는 (v)를 증명해 보겠습니다.

그런데 사실 (v)를 증명하려면 다음 포스팅 내용을 가져와야 하는데요. 아래의 내용은 일단 사실로 받아들입시다.

$\hat{\sigma}^2_{(i)}(n-p-2) = (n-p-1)\hat{\sigma}^2 - \frac{e_i^2}{1-h_{ii}}$

여기서 $\hat{\sigma}^2_{(i)}$은 i번째 data를 leave one out 방식으로 i번째만 제외해서 표본분산을 구한 겁니다!

잘 생각해 보면 , $r_i$는 t분포를 따르지 않습니다. 왜냐면 분자 분모가 독립이어야 t분포가 될 텐데 $\hat{\sigma}$와 $e_i$는 독립이 아닙니다.

그러면 무슨 분포를 따를까요? 우리가 언급한 것과 같이 $\frac{r_i^2}{n-p-1}$이 베타분포를 따릅니다.

목표를 알고 있으니 $U \sim gamma(1/2, 2), V \sim gamma((n-p-1)/2, 2)$ 에 대해 $\frac{U}{U+V}$ 꼴로 나타내봅시다.

유도는 간단합니다.

$\frac{r_i^2}{n-p-1} = \frac{1}{n-p-1} \frac{e_i^2}{\hat{\sigma}^2(1-h_{ii})} = \frac{1}{n-p-1} \frac{1}{\frac{\hat{\sigma}^2}{\sigma^2}} \frac{e_i^2}{\sigma^2(1-h_{ii})}$.

일단 위와 같이 쪼개면 $\frac{e_i}{\sigma\sqrt{1-h_{ii}}} \sim N(0,1)$이라는 사실로부터 $\frac{e_i^2}{\sigma^2(1-h_{ii})} \sim \chi^2(1) = gamma(1/2,2)$임은 쉽게 알 수 있습니다.

다음으로 $(n-p-1)\frac{\hat{\sigma}^2}{\sigma^2}$부분을 위의 식을 사용하여 쪼개어 봅시다.

$\hat{\sigma}^2_{(i)}(n-p-2) + \frac{e_i^2}{1-h_{ii}} = (n-p-1)\hat{\sigma}^2$

$\frac{\hat{\sigma}^2_{(i)}(n-p-2)}{\sigma^2} + \frac{e_i^2}{\sigma^2(1-h_{ii})} = \frac{(n-p-1)\hat{\sigma}^2}{\sigma^2}$

우리가 계산했던 $\frac{e_i^2}{\sigma^2(1-h_{ii})}$식이 나왔습니다 이 부분은 $\chi^2(1)$을 따를 것이고,

$\frac{\hat{\sigma}^2_{(i)}(n-p-2)}{\sigma^2} $ 부분은 i번째 데이터가 애초에 없다고 생각하고 선형회귀를 한 부분이기 때문에 데이터가 $n-1$개 있을 때 $\frac{SSE}{\sigma^2}$의 분포를 구한 것과 같으므로 $chi^2(n-p-2)$를 따릅니다.

그러면 즉 $\frac{r_i^2}{n-p-1} = \frac{gamma(1/2, 2)}{gamma(1/2, 2)+gamma((n-p-1)/2, 2)}$이므로

$\therefore \frac{r_i^2}{n-p-1} \sim Beta(1/2,(n-p-1)/2)$

결론

생각보다 글이 길어져서 다음 포스팅으로 나눠 적어야 할 것 같습니다.

본 글은 Internally Studentized residual(내재적 스튜던트화 잔차?)의 나머지 성질에 대해 알아보았습니다.

Internally Studentized residual가 t-dist를 따르지 않기 때문에 beta를 통해 확인할 수 있다는 점과 그의 분산에 대해 알아보았습니다.

각 분산은 1이었고, cov는 hat matrix로 표현되었습니다.

실제로 studentized residual plot은 Internally Studentized residual로 그리는 게 일반적인 것 같아서 성질을 알고 있는 것이 언젠가 도움이 되지 않을까 합니다.

다음 포스팅은 externally studentized residual과 PRESS, Influential Obervations 등으로 돌아오겠습니다.

끗!

'응용통계' 카테고리의 다른 글

| Chapter 7 Multiple Regression : Model Validation and Diagnostics1 (3) | 2025.05.08 |

|---|